Робота навчили жестикулювати за записами TED Talks

Корейські вчені навчили тривимірну систему супроводжувати промову жестами, використавши 52 години записи виступів спікерів на TED Talks. За допомогою відкритого алгоритму розмітки пози OpenPose і рекуррентної нейромережі їм вдалося навчити систему супроводжувати синтезовану мову правдоподібними жестами, а також використовувати її для управління гуманоїдним роботом. Препринт статті з описом роботи алгоритму опубліковано на arXiv.org.

Крім виробництва та обробки мови для ефективного спілкування з людьми роботи повинні вміти користуватися і невербальними засобами комунікації. Один з таких засобів - вираження емоцій, і в них роботи вже досягли успіху: цього року американські інженери сконструювали робота, який вміє виражати емоції не тільки за допомогою зображення, що змінюється на екрані, але також і використовуючи спеціальні шипи, що імітують мурашки на людській шкірі.

Інший корисний для роботів засіб невербальної комунікації - жести. Навчити їм роботів вирішили корейські вчені з Науково-дослідного інституту електроніки та телекомунікацій (ETRI) і Корейського інституту передових технологій (KAIST) під керівництвом Янгву Юна (Youngwoo Yoon). Вони зібрали датасет з 52 годин записів виступів спікерів на конференціях TED Talks. Жести людей на відео були розмічені за допомогою відкритого алгоритму OpenPose (використовувалися тільки рухи голови, торсу і рук) і співвіднесені з окремими акцентними словами фраз за допомогою рекуррентної нейромережі. У підсумку вийшла система, яка відтворює положення тіла в тривимірному просторі відповідно до синтезованої мови.

Потім вчені попросили 46 осіб оцінити за шкалою від 1 до 5, наскільки вироблені жести, що супроводжують промову, антропоморфні, відповідають сказаному і приємні на вигляд. Добровольці оцінювали рухи створених в OpenSpace «паличок» без видимого об'єкта: вчені використовували для порівняння приклад з датасета (ground truth), приклад, отриманий за допомогою розробленого алгоритму, випадково підібрані рухи, рухи, налаштовані вручну, а також рухи, отримані за допомогою розрахунку найближчих сусідів з датасета. Створені алгоритмом жести перевершили за всіма параметрами всі інші методи, крім ground truth.

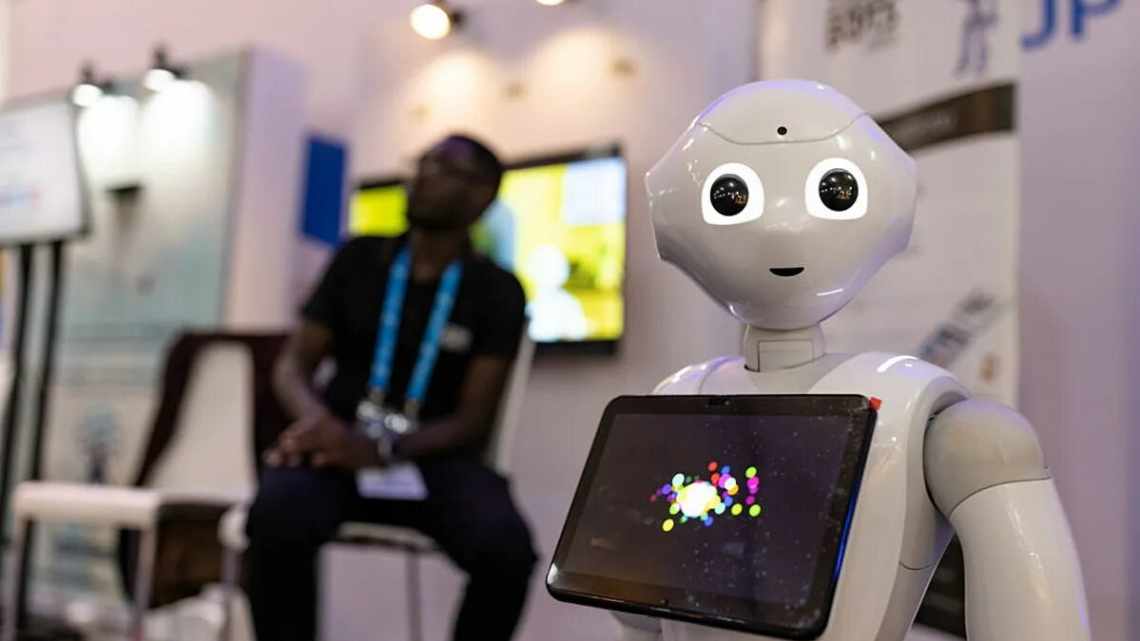

Отриману систему використовували в справжньому гуманоїдному роботі NAO (він часто використовується в дослідженнях взаємодії роботів з людьми): автори роботи стверджують, що роботу вдалося успішно відтворити задані йому комбінації рухів.

Розробники зазначають, що використання в якості даних для навчання відеозапису виступів на TED Talks дозволило їм переконатися в тому, що вироблені жести опрацьовані і добре відповідають мови. Тим не менш, слід враховувати те, що подібні лекції читають професійні спікери, тому дані можуть різнитися з тими жестами, які використовуються людьми в повсякденній промові. Це, однак, вже питання подальшої обробки невербальних засобів комунікації самим роботом.

Подібний до OpenPose алгоритм PoseNet нещодавно використовували для створення своєрідного дзеркала: оцінюючи позу людини під час руху вчені навчили нейромережу шукати і показувати знімки інших людей в точно такій же позі.